La implementación de la inteligencia artificial en nuestro día a día avanza rápidamente. A pesar de las evidencias científicas que muestran que los algoritmos también presentan sesgos discriminatorios, estas operaciones computacionales para la toma de decisiones automatizadas ya se aplican en diferentes ámbitos de nuestras vidas, como la banca, la justicia o los procesos de selección de personal.

La inteligencia artificial también ha llegado a la tecnología militar y, además, con visos de trastocar todo lo establecido por la estrategia militar en los últimos años –como ya ocurrió con la invención de las armas de fuego o las nucleares–. Drones no tripulados han sido usados por el ejército estadounidense durante la última década con el pretexto de que su autonomía evitaba víctimas mortales. Sin embargo, las cifras oficiales de bajas civiles por este tipo de tecnología b. Estos drones sin tripulación están controlados por un humano de forma remota. No ocurre lo mismo con los conocidos como “killer robots” o armas letales autónomas (lethal autonomous weapons o LAWs en inglés).

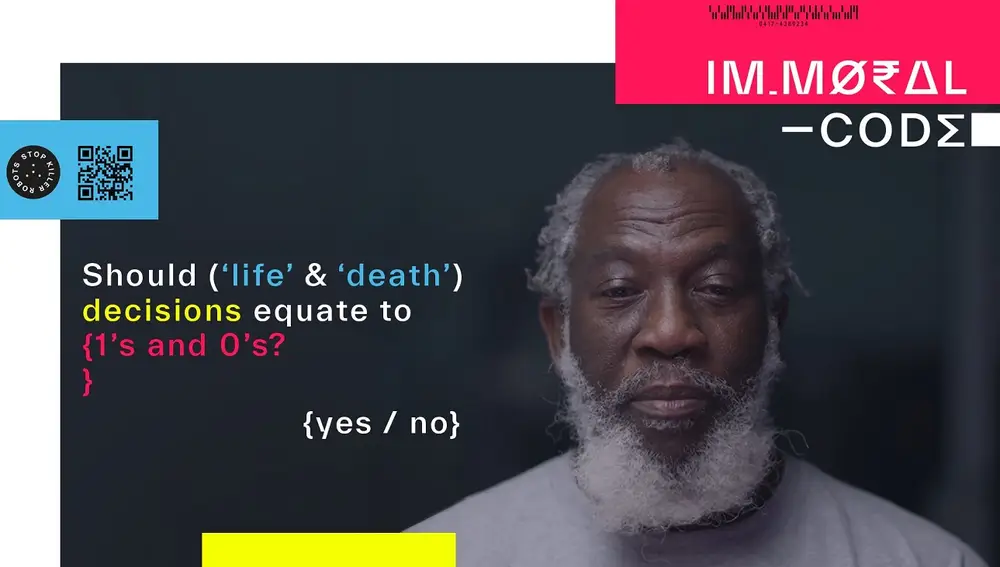

El documental “Immoral Code” se estrenaba esta semana para concienciar sobre los problemas éticos, legales, tecnológicos e incluso sociales que suscita que una máquina decida matar o no a una persona. Producido por la plataforma Stop Killing Robots, cuenta con la participación de diferentes expertos en ética, robótica o estrategia militar. El documental expone la complejidad ética y moral a la que nos enfrentamos los humanos tomando decisiones que implican la muerte de terceros. Delegar estas decisiones en inteligencia artificial sentaría un peligroso precedente, pues la incapacidad de prever con precisión las acciones que desarrollará la IA ya ha sido probada científicamente.

¿Qué dice la legislación internacional sobre las armas autónomas?

A pesar de que esta controvertida tecnología militar ya se ha implementado y usado en recientes conflictos (como la invasión rusa de Ucrania), no existe legislación que la regule a ningún nivel. De ahí que la coalición internacional Stop Killing Robots abogue por su prohibición. Otra organización que trabaja por la regulación de las armas autónomas es la ONG internacional Future of Life Institute. En 2017 se estrenaba “Slaughterbots”, un corto que muestra un futuro distópico con enjambres de mini drones letales. Aunque podríamos etiquetarlo como ciencia ficción, la verosimilitud de la historia nos obliga a cuestionar los límites morales de tecnología que ya existe en nuestro presente.

En la web Autonomousweapons.org se desgranan con detalles los riesgos de permitir que la IA tome decisiones sobre destrucción de objetivos militares. A los riesgos tecnológicos (la impredecibilidad, la escalabilidad o la proliferación, por ejemplo) se suman los escollos éticos y legales. El derecho internacional humanitario establece los principios de distinción –las partes en un conflicto tienen que distinguir entre objetivos civiles y militares, atacando sólo los segundos– y proporcionalidad –el daño causado a objetivos civiles ha de estar justificado en la ventaja militar conseguida–. La Convención de Armas Convencionales de Naciones Unidas (CCW)ya se ha manifestado al respecto, reconociendo a las IAs militares incapaces de cumplir con el derecho internacional humanitario.

La falta de supervisión humana, la clave de las armas letales autónomas

Además de vulnerar derechos humanos, otros problemas éticos que presentan las IA asesinas es que generan un vacío de responsabilidad. Mientras que la Convención de Ginebra establece que las acciones militares son responsabilidad de los mandos que dan las órdenes, no queda claro si un mando militar podría traspasar esa responsabilidad a una máquina. La inmoralidad también planea sobre los robots asesinos ya que las máquinas son incapaces de conceptualizar el valor de la vida humana.

En diciembre de 2021 la CCW se reunía para discutir, regular y legislar sobre armas letales autónomas, partiendo de una guía de recomendación que el organismo había redactado años atrás: los 11 principios no vinculantes de las LAWs. Sin embargo, Rusia y Estados Unidos –las potencias militares en la materia– frustraron las negociaciones, que han continuado tímidamente en un plano informal.

Mientras, las potencias militares globales siguen aumentando su inversión en armas autónomas, evocando la carrera armamentística de la Guerra Fría y todos sus fantasmas. En el campo de batalla, estos drones kamikazes seguirán eliminando objetivos sin ser escrutados por el derecho internacional.