Hace poco –no más de una década– los científicos fueron capaces de establecer qué estaba mirando una persona por la forma en que se iluminaba el cerebro. Al principio, Jack Gallant, neurocientífico informático de la Universidad de California, y su equipo solo pretendían comprender qué regiones cerebrales se activan cuando una persona ve, por ejemplo, un gato, una naranja o una bicicleta. Al final, la investigación fue más allá: utilizaron inteligencia artificial (IA) –el aprendizaje automático de una máquina (machine learning)– para descifrar qué cosas estaba viendo una persona a través de la actividad cerebral. Los voluntarios se introdujeron en máquinas de resonancia magnética y allí visualizaron durante horas fragmentos de películas en movimiento que provocaban una actividad cerebral. La IA analizó todos esos patrones de actividad cerebral para construir un modelo del funcionamiento de la corteza visual. La máquina aprendió a traducir lo que estaban mirando los ojos. Los resultados, publicados en 2011, fueron alucinantes: la máquina transformó en una imagen en movimiento totalmente comprensible para los espectadores lo que había leído en el cerebro. Quizá tenían menos detalles y eran más expresionistas que las imágenes reales pero casi calcaron los que los voluntarios veían con sus propios ojos. En el artículo Los lectores de la mente tienes más información

La conexión entre computadora y cerebro humano avanza sin que nos demos cuenta, centrada más en la salud, en cómo mejorar la calidad de vida de personas con tetraplejia, por ejemplo. Según dijo Rafael Yuste, neurobiólogo de la Universidad de Columbia, a The New York Times, “la tecnología no invasiva de lectura de cerebros será el tercer gran salto tecnológico después de los ordenadores personales que caben en un escritorio y de los teléfonos inteligentes”. En esto también está el magnate tecnológico Elon Musk y su proyecto de implantes cerebrales que permitirán comunicarse con ordenadores, manejar un dispositivo solo con pensarlo.

Recientemente le ha tocado el turno a un grupo de investigadores de la Universidad de Helsinki, que ha creado una interfaz cerebro-computadora para predecir nuestros pensamientos y plasmarlos en imágenes. Lo que hizo el equipo de Gallant pero evolucionado. Sus resultados fueron publicados el pasado 7 de septiembre en la revista Scientific Reports, donde presentaron lo que denominan ‘modelo generativo autoadaptativo’, que utiliza señales cerebrales como retroalimentación para generar nueva información que coincida con las intenciones del participante. Vamos, que el modelo computacional sabe lo que estamos pensando y lo puede representar en imágenes. Y todo esto con una sencilla interfaz cerebro-ordenador. Los científicos finlandeses explican que, hasta el momento, las técnicas neuroadaptativas tenían éxito en tareas básicas como el control mental del movimiento de un cursor en la pantalla.

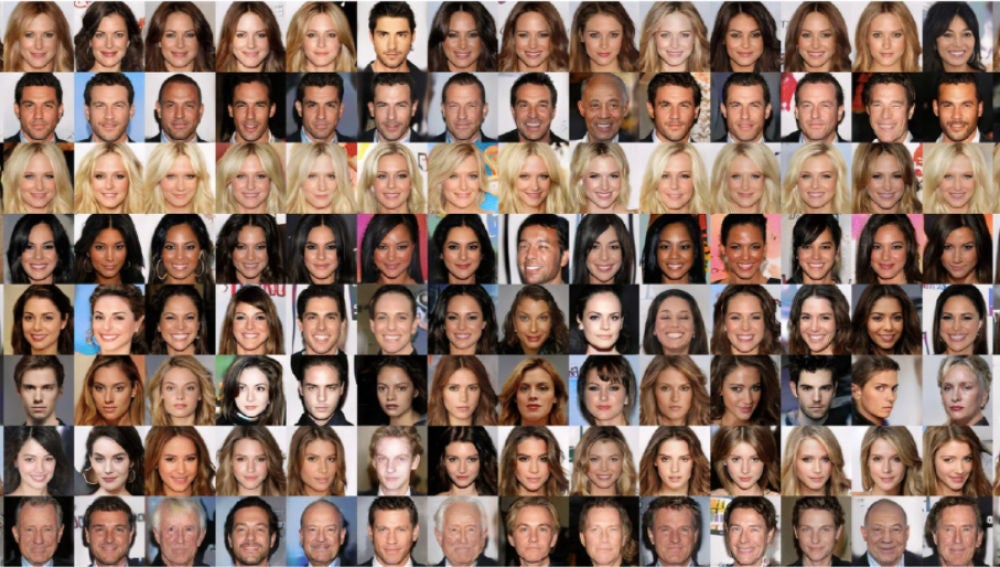

En este caso, a los participantes, una treintena de voluntarios, se le mostraron cientos de imágenes creadas por una inteligencia artificial de personas con distinta apariencia y al mismo tiempo se grababa su electroencefalograma para ver qué actividad cerebral generaban. Con todas esas señales, la red neuronal era capaz de adaptarse y estimar en qué tipo de rostro estaba pensando el voluntario. Luego, la IA plasmó en imágenes el tipo de cara en que pensaba la persona. El grado de acierto fue del 83 %.

“Las imágenes resultantes lograron una concordancia casi perfecta entre el resultado del modelado generativo neuroadaptativo (…) Si bien, en la actualidad, las características visuales estudiadas eran deliberadamente sencillas (como el género, el color del cabello, la edad y la sonrisa) y en un dominio relativamente restringido (rostros humanos), los resultados muestran que el paradigma de modelado generativo neuroadaptativo se puede utilizar para recopilar información sobre conceptos subjetivos muy complejos, como rasgos faciales específicos”, explicaron en el Scientific Reports.