El vídeo dio la vuelta al mundo. El actor, comediante, director y guionista estadounidense Jordan Peele utilizaba la imagen de Barak Obama y la fusionaba con su propia voz para lanzar una advertencia contra los deepfakes (falsificaciones profundas, en su traducción literal del inglés). Fue en 2018. En 2019 los expertos alertaron de que los deepfakes pasarían del mundo de los políticos y los famosos a los líderes empresariales.

Un año después, el periódico The Wall Street Journal contaba que el director general de una empresa energética no identificada con sede en el Reino Unido creía que estaba hablando por teléfono con su jefe, el director general de la empresa matriz alemana, cuando siguió las órdenes de transferir inmediatamente 220.000 euros a la cuenta bancaria de un proveedor húngaro. En realidad, la voz pertenecía a un estafador que utilizaba la tecnología de voz de la inteligencia artificial para suplantar al director general alemán.

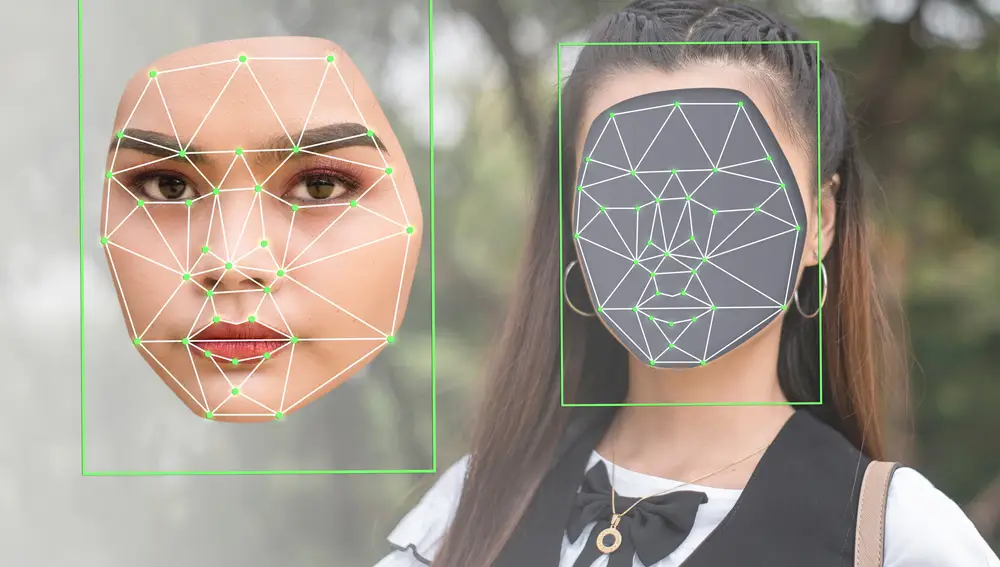

A través de un software y en muy poco tiempo cualquiera puede manipular lo dicho por una persona a partir de un vídeo falso. Los ejemplos son infinitos, pero lo mas preocupante es que más del 90 % de los vídeos falsos online son pornográficos y afectan principalmente a las mujeres.

Cualquiera esta expuesto a los montajes

Es tan fácil la manipulación que algunas apps lo hacen directamente sin tener que recurrir a herramientas demasiado sofisticadas. Es el caso del software Deep Nostalgia, una aplicación que permite animar fotografías antiguas con la promesa de 'resucitar' a personas de nuestro pasado.

Cualquiera puede ser víctima de un deepfake. El fenómeno es cada vez más popular y la inteligencia artificial se encarga de hacerlo posible. Cualquiera está expuesto a ser el protagonista de un vídeo o un audio falso que puede cambiarle la vida.

Por eso es muy importante saber qué herramientas tenemos a mano para defendernos de uno de ellos antes de que nuestro supuesto yo empiece a circular por la red diciendo algo que jamás hemos pronunciado. Hasta Microsoft creo una herramienta para poder detectar estos vídeos falsos.

Son varias las circunstancias en las que se usan deepfakes con intenciones fraudulentas, por eso el Instituto Nacional de Ciberseguridad (INCIBE), que pertenece al Ministerio de Asuntos Económicos y Transformación Digital, da algunos consejos básicos sobre cómo actuar si somos víctimas de uno de ellos:

- Solicitar a la cuenta que lo subió que lo borre

- Denunciar lo ocurrido ante la Policía

- Notificar el incidente a INCIBE-CERT

En España aún no existe regulación específica sobre este fenómeno, pero la ley nos ampara dependiendo de los casos y en función del objetivo que tenga la suplantación de identidad. Si esta se hace para robarle los datos bancarios a una persona, el delito está contemplado en el Código Penal.

El uso de imágenes reales puede generar una indemnización y, si es especialmente denigrante, puede conllevar un delito por calumnias e injurias. Por otro lado, en el caso de las conocidas como “pornovenganzas” el delito puede ser perseguido por vía civil o penal (dependiendo de si es un delito de calumnias e injurias o una intromisión al derecho al honor o a la propia imagen.

Hace unos meses una marca de cervezas utilizó la imagen de Lola Flores para uno de sus anuncios. En el vídeo la artista, que murió en 1995, parecía estar hablando hoy mismo sobre lo que es el quejío o el acento. Hasta su propia familia se quedó impresionada con el gran parecido de esas imágenes y su voz a las de la folclórica. Este no es más que un ejemplo de cómo la IA puede devolver a la vida a una persona fallecida. ¿Qué no podrá hacer para conseguir suplantar nuestra identidad?