“Debido a las graves deficiencias y riesgos que presentan los sistemas de reconocimiento y análisis facial, los posibles beneficios que quizás podrían ofrecer no compensan de ninguna manera sus potenciales efectos negativos, en especial para los grupos y colectivos que suelen sufrir injusticias y tratos discriminatorios: entre otros, mujeres, personas LGTBIQ, personas racializadas, migrantes, personas con discapacidad o en situación de pobreza o exclusión”. Más de 70 catedráticos, profesores e investigadores de prestigio en el ámbito de la Filosofía, Computación y Ciencias Sociales han enviado una carta solicitando al Gobierno español una comisión de investigación que estudie la necesidad de establecer una moratoria “en el uso y comercialización” de estos sistemas de reconocimiento facial por parte de empresas públicas y privadas.

Los firmantes muestran su preocupación por la velocidad a la que se están extendiendo estas técnicas y con los “efectos perniciosos” que pueden tener sobre el bienestar, los intereses, las necesidades y los derechos de la población española”. Y por ello piden una “intervención rápida” al Ejecutivo de Pedro Sánchez. Hace poco más de un mes os contamos en Levanta la cabeza que esta tecnología con fines de videovigilancia empezaba a no tener freno. Un total de 109 países –32 en Europa– utilizan o han aprobado ya su uso, y el contexto pandémico está acrecentando la investigación para perfeccionar estos sistemas. En junio pasado, más de 2.000 sociólogos, científicos, antropólogos y juristas condenaron el uso de la inteligencia artificial (IA) en el desarrollo de algoritmos para predecir crímenes basándose en datos biométricos (rostro de la persona) que pueden tener un sesgo racial.

Gafas policiales y empresas españolas

En España tenemos varios ejemplos. Empresas y universidades españolas están desarrollando tecnología de control biométrico con realidad aumentada e inteligencia artificial para uso policial capaz de identificar un rostro con mascarilla. Estas gafas policiales, cuyo proyecto está asesorado y supervisado por el Ministerio del Interior, tendría como objetivo distinguir a un delincuente entre una multitud. El objetivo del programa AI MARS es rastrear millones de caras por segundo en grandes eventos, estaciones, centros comerciales y manifestaciones.

Por otra parte, RENFE ha sido la última empresa española en admitir que utilizará técnicas de reconocimiento facial para controlar el aforo en estaciones y andenes, y vigilar a los que se cuelan, montan peleas o pintan grafitis. La prueba piloto pretende realizarla en estaciones de Cercanías de Barcelona y Madrid. En febrero se conoció el pliego de licitación, que luego retiró, para el desarrollo de un software de análisis de vídeo en 25 estaciones por un valor de casi 800.000 euros. Sin olvidar que el aeropuerto Adolfo Suárez-Barajas de Madrid ya cuenta con un sistema de reconocimiento biométrico para facturar y embarcar o que la cadena Mercadona anunció que había contratado una empresa israelí para su plan de videovigilancia por reconocimiento facial en sus supermercados.

Intromisión en la esfera privada

Los catedráticos reclaman la intervención del Gobierno “de manera rápida” antes de que estos sistemas continúen expandiéndose y se conviertan “en estándares de facto, a pesar de la intromisión que suponen en la esfera privada de las personas sin su consentimiento explícito”. Están en juego, dicen los firmantes, cuestiones fundamentales “de justicia social, dignidad humana, equidad, igualdad en el trato e inclusión”.

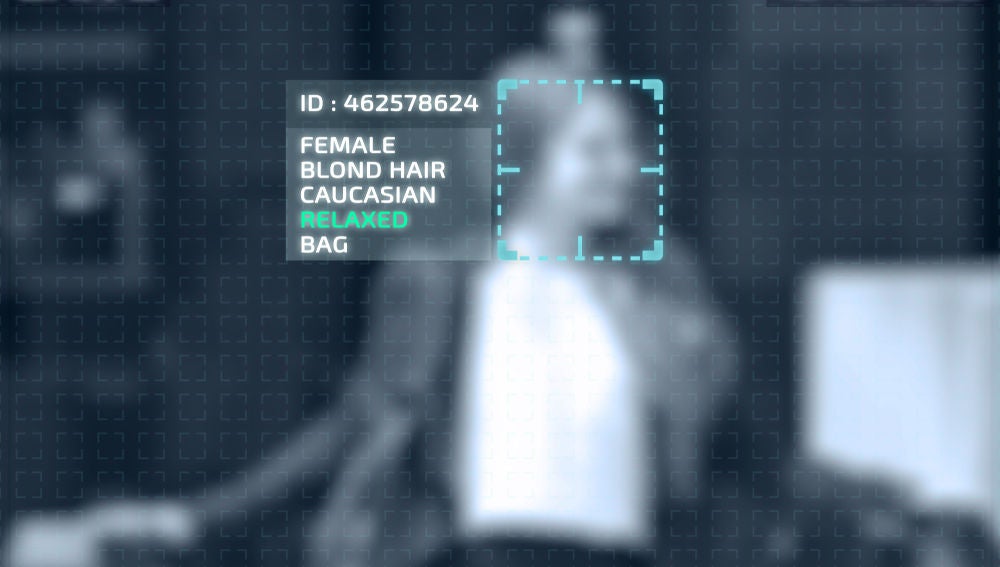

En la carta explican que los sistemas de reconocimiento de imágenes de personas (de sus caras, gestos, peinados, posturas, vestimenta, movimientos, color de piel, etc.) y los algoritmos de aprendizaje automático que los sustentan “tienen graves problemas que han sido ampliamente documentados y discutidos por la comunidad científica y entidades gubernamentales y civiles”. Además, destacan “el profundo condicionamiento coercitivo que trae aparejada una vigilancia ubicua” y cómo afecta a cuestiones como privacidad y seguridad en el tratamiento de los datos.

Caja negra, sesgos y fallos

Entre los argumentos para desconfiar de esta tecnología de reconocimiento, enumeran cinco principales: Asociar a una persona una determinada característica o tendencia con base en estadísticas “es altamente problemático”; no hay métodos científicos aceptados en psicología, antropología o sociología “que indiquen que un tipo de nariz o una manera de andar sean predictores adecuados de comportamientos individuales futuros”; estos sistemas se consideran cajas negras cuya opacidad dificulta saber cómo funcionan; “son poco robustos y dan lugar tanto a falsos positivos como a falsos negativos”; y es fácil que un sesgo en la muestra afecte a la calidad predictiva “cuando diferentes grupos no están representados de forma igualitaria en los datos de entrenamiento”.

Por ello, solicitan una comisión independiente compuesta por científicos, juristas, expertos en ética e inteligencia artificial y por miembros de la sociedad civil que investigue la necesidad de una moratoria en el uso de esta tecnología “al menos hasta que las Cortes y las instituciones legislativas europeas debatan si debe permitirse, y de qué forma, la utilización de estos sistemas”.

Entre los catedráticos, profesores e investigadores de universidades e instituciones académicas de toda España que han firmado esta petición, se encuentran la miembro del comité de expertos de Levanta la cabeza Ofelia Tejerina, presidenta de la Asociación Internautas; y dos de mujeres expertas en ética digital que han sido entrevistadas en Levanta la cabeza recientemente: Manuela Battaglini, abogada y consultora de ética digital, y Carissa Véliz, profesora asociada de Filosofía en Oxford y autora de ‘Privacidad es poder”.

Los más de 70 firmantes –la carta sigue abierta para nuevas incorporaciones– quieren aprovechar para abrir un debate en la sociedad “acerca del rol que estos sistemas pueden jugar en nuestras vidas y bajo qué condiciones”.